算力才是ChatGPT核心竞争力!

时间:2023年02月10日 08:53:58 浏览:次

[摘要] 轻指数重个股

正文

2023年02月10日 08:53:58

算力才是ChatGPT核心竞争力?AI芯片被推至聚光灯下

ChatGPT的技术底座是“大型语言模型(Large Language Models)”,简称LLMs,中文习惯称为“大模型”。算法是大模型成功的首要条件,然后要喂给算法海量的数据(数据量级跃升,能带来更多能力的涌现),再搭配强大的发动机——大算力,才能获得最基础的大模型。

一个ChatGPT应用的算力消耗已经让人瞠目。其大模型GPT经历了三次迭代,GPT、GPT-2和GPT-3(当前开放的版本为GPT-3.5)的参数量从1.17亿增加到1750亿,预训练数据量从5GB增加到45TB,其中GPT-3训练单次的成本就已经高达460万美元。最新的GPT3.5在训练中使用了微软专门建设的AI计算系统,由1万个V100 GPU组成的高性能网络集群,总算力消耗约3640PF-days,即假如每秒计算一千万亿次,需要计算3640天。

同样,国产自研的源1.0、悟道和文心等AI模型,不仅在参数量上达到了千亿级别,而且数据集规模也高达TB级别。想要搞定这些“庞然大物”的训练,就至少需要投入超过1000PetaFlop/s-day(PD)的计算资源。

一言以蔽之,大模型为代表的AI新时代,算力便是核心竞争力。

而AI 芯片是针对人工智能算法做了特殊加速设计的芯片,也被称为AI加速器或计算卡,是AI的算力基础。要知道,ChatGPT有着大量复杂计算需求的AI模型,GPU、FPGA、ASIC等AI芯片专门用于处理这些计算任务,是不可或缺的底层硬件。

据了解,采购一片英伟达顶级GPU成本为8万元,GPU服务器成本通常超过40万元。对于ChatGPT而言,支撑其算力基础设施至少需要上万颗英伟达GPU A100,一次模型训练成本超过1200万美元。

浙商证券分析师陈杭据此表示,ChatGPT对于高端芯片的需求增加会拉动芯片均价,量价齐升将导致芯片需求暴涨,“目前OpenAI已推出20美元/月订阅模式,初步构建了优质的订阅商业模型,未来继续扩容的能力将会大幅提升。”

中金公司认为,未来大模型趋势下,AI芯片市场成长可期,在ChatGPT应用大规模商用初期,AI芯片行业有望创造20亿美元左右市场空间。另据Omdia,2022年数据中心用AI芯片市场规模有望达133亿美元。

多路线蕴含潜力 周边生态有望受益

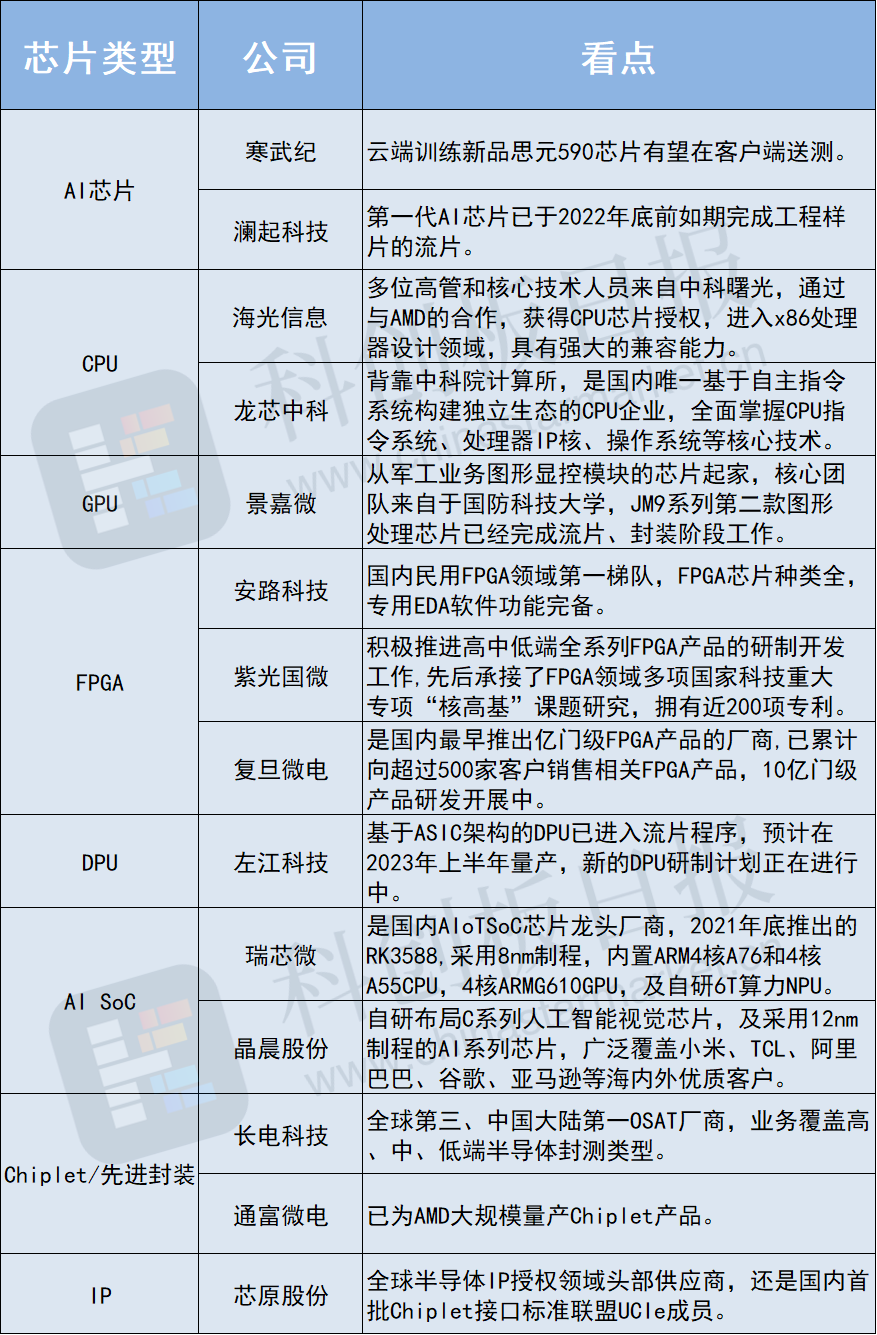

不过,在名为“AI芯片”的大篮子里,细分品类众多。目前英伟达主导的GPU凭借高算力成为主流选择,其他AI芯片如ASIC、DPU、FPGA也蕴含潜力——

ASIC/DPU等专用芯片在特定使用场景下高算力/低功耗/小面积的优势仍吸引国内外厂商积极布局,如TPU、类脑芯片等;FPGA由于可编程而更具灵活性,相比于CPU/GPU/ASIC具有更高的速度和极低的计算能耗,常年来被用作专用芯片的小批量替代品。

作者不愿公开自己是否持有文中所涉及的股票或其他投资组合。

本文仅代表撰稿人个人观点,不代表摩尔投研平台。

发表评论